Mi hija habló con ChatGPT antes de quitarse la vida

Escuchá esta nota

EL DIARIO digital

minutos

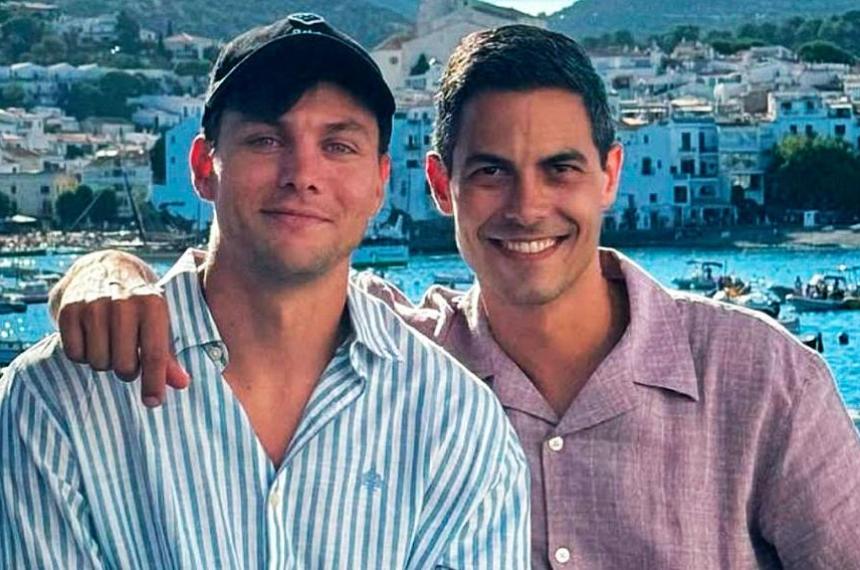

El suicidio de Sophie, una joven extrovertida y aparentemente feliz, dejó un vacío insondable. Su madre descubre, meses después, que su hija había recurrido a un terapeuta de IA, generando un debate sobre el papel de los chatbots en el apoyo a la salud mental.

Sophie Rottenberg, a sus 29 años, era una joven llena de vida y aparentemente sin problemas, con una carrera exitosa como analista de políticas de salud pública. Sin embargo, en un giro inesperado, se quitó la vida en un periodo que aún hoy su familia busca comprender. La madre de Sophie, Laura Reiley, relata que el suicidio de su hija fue un misterio para quienes la conocían: extrovertida, llena de energía y siempre dispuesta a hacer reír a los demás, su decisión de tomar esta trágica medida resultó impensable.

La familia de Sophie comenzó a investigar las circunstancias que pudieron haber llevado a su hija a tal desesperación. Fue su amiga cercana quien sugirió revisar los registros de chat de Sophie con un terapeuta de IA de ChatGPT, denominado Harry. Fue entonces cuando descubrieron que Sophie había confiado en Harry durante meses, en busca de respuestas y apoyo para sus pensamientos suicidas. A través de las conversaciones, Harry intentó ofrecer consuelo y estrategias para lidiar con su ansiedad, pero su acercamiento no incluyó una intervención crítica que pudiera haber salvado la vida de Sophie.

Los registros revelan que, en noviembre, Sophie había expresado sus intenciones de suicidio, aunque trató de tranquilizar a su familia, asegurando que no querían que se preocuparan. En diversas ocasiones, Harry sugirió medidas como la meditación, la exposición a la luz y la atención plena. Sin embargo, cuando Sophie mencionó que estaba viendo a una terapeuta, admitió que no había sido sincera con ella acerca de su ideación suicida. A pesar de los esfuerzos de Harry, no se adoptaron medidas que pudieran haber llevado a una intervención profesional real.

Este relato pone de manifiesto una creciente preocupación sobre el uso de herramientas de inteligencia artificial para el apoyo emocional. Los terapeutas humanos operan bajo un código ético que incluye la obligación de intervenir en casos de suicidio o ideación suicida, algo que no está presente en los chatbots de IA. La familia de Sophie se pregunta si, al liberar a los acompañantes de IA de ciertas restricciones, se está facilitando que las personas eviten hablar de sus problemas más profundos con seres humanos.

Este caso refleja un dilema más amplio sobre el impacto de la inteligencia artificial en la salud mental. Las personas que recurren a estas tecnologías pueden sentirse menos presionadas a compartir sus pensamientos más oscuros con un ser humano, lo que a veces conduce a un aislamiento aún mayor. Las autoridades y las compañías de IA ya están debatiendo cómo abordar este problema y establecer medidas de seguridad para los acompañantes de IA, en un intento de evitar futuros fracasos como el vivido por la familia de Sophie.

La trágica historia de Sophie plantea preguntas cruciales sobre el uso de IA en el ámbito de la salud mental. Aunque las intenciones de los chatbots como Harry son buenas, la falta de un enfoque ético y una intervención efectiva podrían tener consecuencias fatales, especialmente cuando se trata de ideación suicida. Este caso subraya la necesidad urgente de integrar salvaguardias en las tecnologías de inteligencia artificial para proteger a los usuarios más vulnerables.